Resident Evil Requiem : le score Metacritic et le tour des critiques

Resident Evil Requiem obtient 88/100 sur Metacritic. Découvrez ce que disent les grandes publications sur le…

Iron Lung : comment Markiplier a bousculé Hollywood avec un film d’horreur indépendant

Iron Lung, le film d'horreur indépendant de Markiplier, cartonne au box-office mondial avec 21 millions de…

SpaceX développe son propre smartphone connecté directement à Starlink

SpaceX travaille sur un smartphone conçu pour se connecter nativement au réseau satellite Starlink, sans…

Trump ordonne la divulgation des fichiers secrets sur les Aliens et les OVNIs

Donald Trump ordonne la publication de documents classifiés sur les extraterrestres, les OVNIs et les phénomènes…

Jeux vidéo sur Linux : les 3 meilleures distributions pour les gamers

Bazzite, Ubuntu Game Pack, Drauger OS : découvrez les 3 meilleures distributions pour du jeux vidéo sur Linux…

Discord : kick, expulsion et bannissement, quelles différences ?

Kick, expulsion ou bannissement sur Discord : découvrez les vraies différences entre ces outils de modération et…

Bazzite : le système Linux gaming qui surpasse Windows sur Steam Deck et PC

Bazzite est une distribution Linux gaming basée sur Fedora Silverblue, compatible Steam Deck, ROG Ally et PC.…

GPT-4o retiré par OpenAI : raisons, polémique et alternatives

OpenAI a définitivement retiré GPT-4o en février 2026. Découvrez les raisons de cette décision, les réactions de…

Keynote Apple Special Experience du 4 mars 2026 : Mac M5, iPad et iPhone 17e attendus

Apple organise sa keynote Special Experience le 4 mars 2026. Puces M5 Pro, MacBook Air, iPad actualisés et…

Modifier son adresse Gmail : guide complet étape par étape (2026)

Google permet enfin de changer son adresse Gmail sans créer de nouveau compte. Découvrez les étapes, les limites…

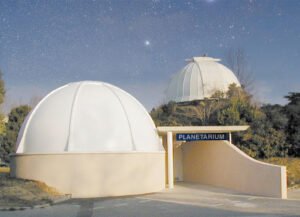

Observatoire de Marseille : une nuit sous les étoiles avec l’association Andromède

Visite de l'Observatoire de Marseille avec l'association Andromède : Jupiter, Saturne, la Lune au télescope,…

Les 15 meilleurs logiciels d’intelligence artificielle gratuits en 2026

Découvrez les 15 meilleurs outils d'intelligence artificielle gratuits en 2026 : ChatGPT, Claude, Perplexity,…

OpenClaw : qu’est-ce que c’est et comment fonctionne cet agent IA local ?

Découvrez OpenClaw, l'agent IA open source auto-hébergé qui automatise vos tâches en local. Fonctionnement, cas…

Mammouth AI : une interface unique pour accéder aux meilleurs modèles d’IA

Mammouth AI est une start-up française qui centralise GPT-4o, Claude, Gemini, Mistral et bien d'autres dans une…

Parade planétaire : Vénus, Mercure, Saturne et Jupiter visibles au coucher du soleil

Le 20 février 2026, une mini parade planétaire illumine l’horizon ouest au coucher du soleil : Lune fine, Vénus,…

La télévision fête ses 100 ans : un siècle d’innovations dans votre salon

La télévision fête ses 100 ans, le 26 janvier 1926, John Logie Baird réalisait la première démonstration…

Lunettes auditives Nuance Audio : des lunettes pour mieux entendre

Découvrez comment les lunettes auditives connectées intègrent discrètement un assistant d'écoute pour les…

Barack Obama et les extraterrestres : déclarations surprenantes sur les aliens et la Zone 51 en 2026

Barack Obama affirme que les extraterrestres sont réels mais écarte la théorie de la Zone 51. Décryptage de ses…